Retour sur le salon Data et IA Nantes: soutenabilité, projets atypiques et nouvelles technos

Le mardi 19 Septembre dernier a eu lieu le 8ème Salon de la Data et l’IA à Nantes. Je n’étais pas sur place, mais grâce à la magie de la technologie, j’ai pu assister à plusieurs conférences que j’avais identifiées en amont.

Dans cet article, je vous propose un résumé de certaines d’entre elles. Si les questions environnementales, la Data science, les architectures Data ou encore les vaches vous passionnent, vous y trouverez sûrement (ou du moins je l’espère) votre bonheur !

Petit disclaimer: J’ai décidé d’être originale, je me suis lancé le défi de ne pas parler d’IA générative dans cet article 🤖

La donnée “verte”, une utopie ? ☘️

Les défis environnementaux sont au cœur des débats et c’est très légitimement que je me questionne de plus en plus sur l’impact environnemental de mes actions en tant que professionnelle de la “data”.

J’ai donc été naturellement interpellée par la conférence “La data, un atout pour soutenir vos enjeux liés à la décarbonation?” donnée par deux consultants de Wavestone, Charlotte Maillard et Antoine Choffel. Au-delà de la réponse à cette question fermée, j’étais surtout intéressée pour avoir des pistes actionnables d’éco-conception pour les usages “data”, et je n’ai pas été déçue !

Comme l’explique Charlotte Maillard dans son introduction, Wavestone souhaite, entre autres, répondre à la problématique de ses clients de mettre en place des cas d’usage data à impact positif du point de vue environnemental.

Qui dit impact positif, dit que l’impact environnemental négatif irrémédiablement généré par le cas d’usage data doit impérativement être compensé : tout devient une question de “balance”.

Note: Justement sur la question de compensation, on pourrait se demander si le fait d’avoir une solution pour “effacer” de manière calculatoire l’empreinte environnementale du cas d’usage n’encourage pas à mettre de côté d’autres bonnes pratiques de sobriété. Ce potentiel “effet rebond”, qui est d’ailleurs encore évoqué plus loin, n’est pas le sujet du talk mais pousse un peu plus au questionnement.

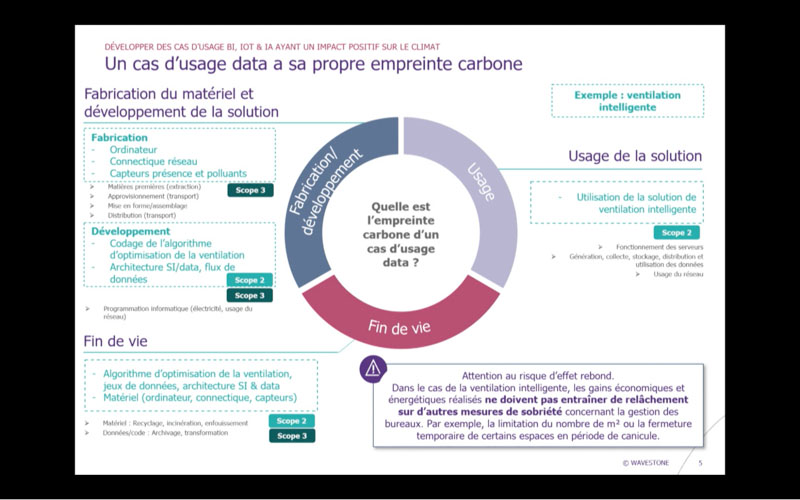

Le point essentiel de la réflexion des deux consultants est de pouvoir mesurer l’impact environnemental du projet dès sa conception et tout au long de son cycle de vie; de la même manière qu’on calcule un ROI et qu’on réalise des bilans comptables pour valider la valeur ajoutée pécuniaire dudit projet.

Un des outils évoqués pour réaliser cette tâche est … le bilan carbone ! Au même titre qu’une entreprise ou un individu, on peut commencer par estimer le coût environnemental du projet data, du matériel utilisé pour l’implémenter (Scope 3) à sa fin de vie en passant par la consommation énergétique liée à son usage (Scope 2).

Nos speakers ont illustré leurs propos par un exemple de cas d’usage mis en place par un de leurs clients : optimiser le système de ventilation et permettre le renouvellement et le rafraîchissement de l’air intérieur en se basant sur des données de capteurs (pollution intérieure, température, …), la météo et autres variables exogènes.

Le gain d’un tel système est évident sur le plan énergétique, mais quid de son bilan carbone et du potentiel effet rebond ?

La question que je me suis tout de suite posée en voyant cette slide, c’est “ok ça paraît cohérent, mais comment on fait le calcul ?”.

Pour tout ce qui est scope 2 encore, notamment pour la consommation énergétique, l’utilisation d’un “Carbon Management System” peut être une solution (un exemple pourrait être le Cloud Carbon Footprint implémenté en serverless par Devoteam Revolve pour le CREA Mont-Blanc).

Par contre pour le scope 3, on doit s’imaginer connaître l’impact environnemental de chaque matériel informatique impliqué dans le projet, ce qui sous-entend avoir une idée à minima du bilan carbone de l’entreprise qui fabrique ce matériel.

Charlotte Maillard a d’ailleurs avoué lors des questions/réponses que cette partie du bilan pouvait être difficile à estimer, car elle est très liée au sourcing amont du matériel informatique, et aux informations que mettent à disposition les fournisseurs.

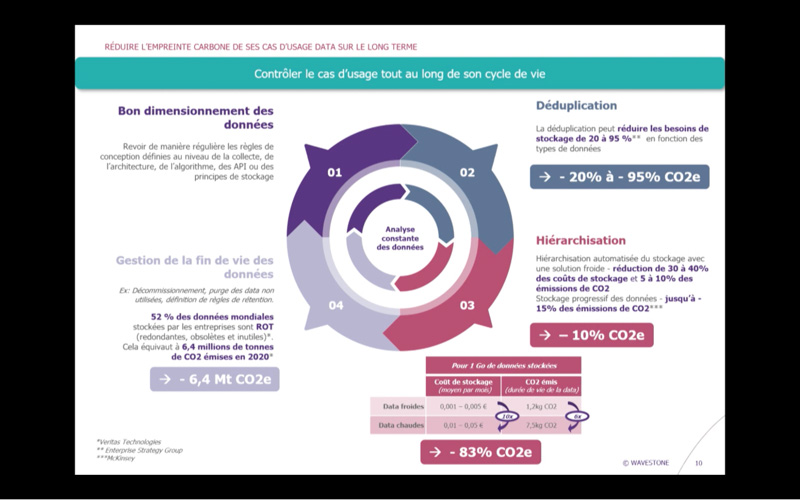

Les deux consultants nous ont ensuite présenté des pistes de bonnes pratiques à mettre en place afin de mieux contrôler l’impact carbone d’un projet data (les chiffres viennent de rapports de diverses entreprises de conseil).

Je n’ai pas pu vérifier toutes ces sources, mais je peux convenir que la duplication et le stockage intensif de la donnée est un problème au sein des Data Warehouses, et que des purges ciblées et régulières permettraient sûrement de libérer une bonne partie du stockage utilisé dans les data centers (cela me fait penser qu’il faut que je vide ma boîte mail ^^).

En bref, les speakers ont convenu avec nous que cette approche “Green Data by Design” en était encore au stade “embryonnaire” et qu’elle devait être éprouvée, notamment en prenant en compte d’autres métriques que l’empreinte carbone pour quantifier l’impact environnemental. Plus encore, il s’agit là d’un défi d’acculturation des métiers de la data aux enjeux de sobriété numérique.

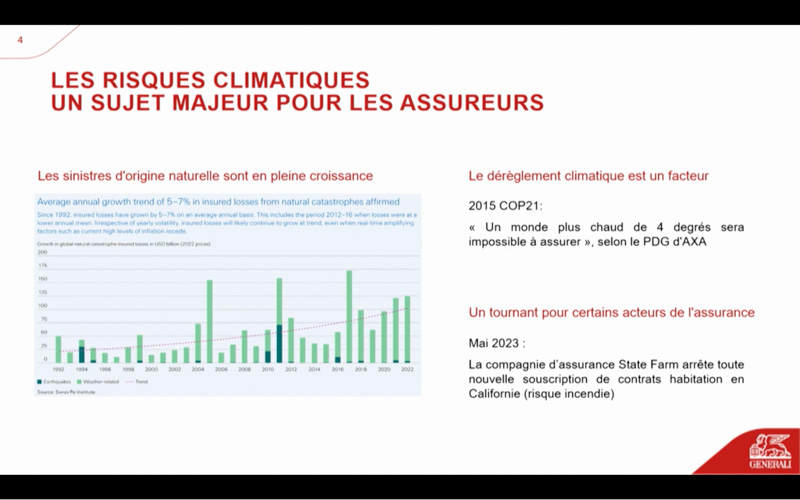

Quoi qu’il en soit, le changement climatique est déjà bien réel, et comme vous pouvez vous en douter, les compagnies d’assurance en paient déjà le coût.

La Data Science pour estimer le risque climatique chez Generali 🌧️

J’ai mis cette conférence dans ma “To view List” car elle fait un peu écho à la première : on passe d’une action sur une des causes du changement climatique (ici l’émission de CO2) à des actions visant à gérer les conséquences de cette réalité.

Les évènements climatiques sont devenus de plus en plus imprévisibles ces dernières années, au grand dam des assureurs qui doivent trouver des solutions pour pallier les risques de sinistres fluctuants de leurs assurés.

Chez Generali, la bataille est lancée contre les grêlons. D’après Amandine Gomez, speakerine sur ce sujet, “l’année 2022 a coûté plus de 10 milliards aux assureurs français”, notamment dus à la grêle (5,1 milliards).

Ce constat a suscité la mise en place d’une thèse CIFRE, réalisée par Maxime Frevisani, dont l’objectif est de quantifier le risque grêle, pour notamment fixer des primes d’assurance soutenables.

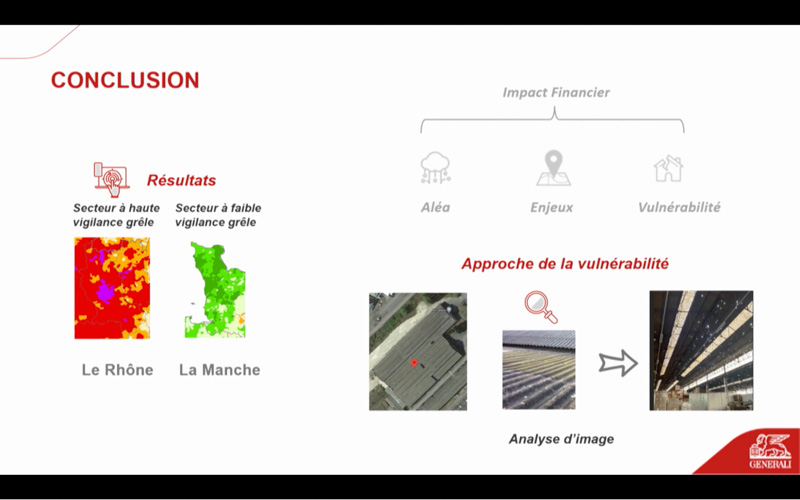

L’approche de l’équipe repose sur 2 aspects:

- l’estimation de l’aléa climatique lié au risque spatial (combien de chances j’ai d’avoir de la grêle dans le Rhône plutôt que dans la Manche par exemple)

- L’estimation de l’impact financier pour l’assureur si un sinistre devait arriver dans telle ou telle zone géographique

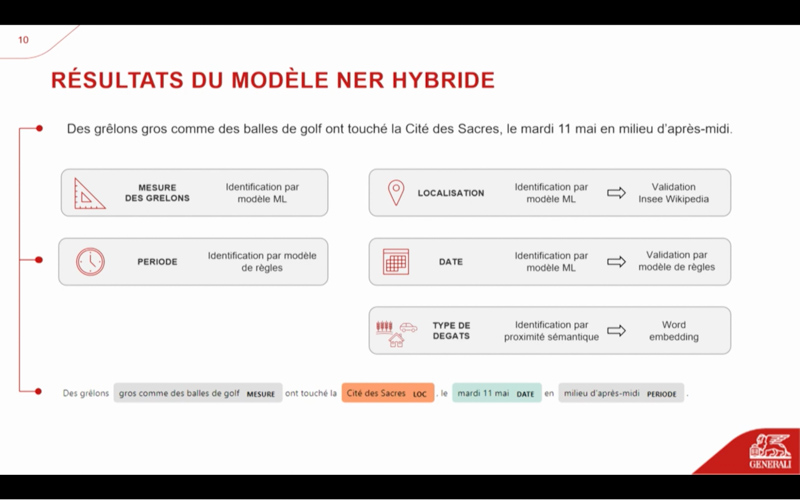

Pour répondre à cette problématique, les data scientists travaillant sur le sujet, se basent sur des données structurées (base de données de sinistres) mais aussi non structurées comme des articles de journaux. Ils ont donc dû utiliser des algorithmes de type “Named Entity Recognition” (NER) afin d’extraire des informations de date, de localisation et d’intensité des événements de grêle.

Par ailleurs, les travaux d’estimation de l’impact financier sont en cours, et se basent sur l’analyse d’une base de données d’images permettant d’identifier les dégâts matériels causés par les grêlons.

Cette présentation a permis de mieux comprendre l’utilité de la donnée vis-à-vis des enjeux liés au secteur de l’assurance; enjeux qui nous impacteront sûrement tous et toutes dans le futur.

La donnée, de la ville à la ferme 🐮

Assez parlé du climat, revenons à des sujets plus terre à terre. Vous êtes vous déjà demandé comment la donnée pourrait être utile à une vache ? Personnellement moi non, mais j’estime que c’est une information pour le moins importante 😀. Et pour la petite histoire, Devoteam Revolve avait réalisé en 2018 un projet data sur la filière bovine, dont vous pouvez retrouver le retour d’expérience sur notre blog !

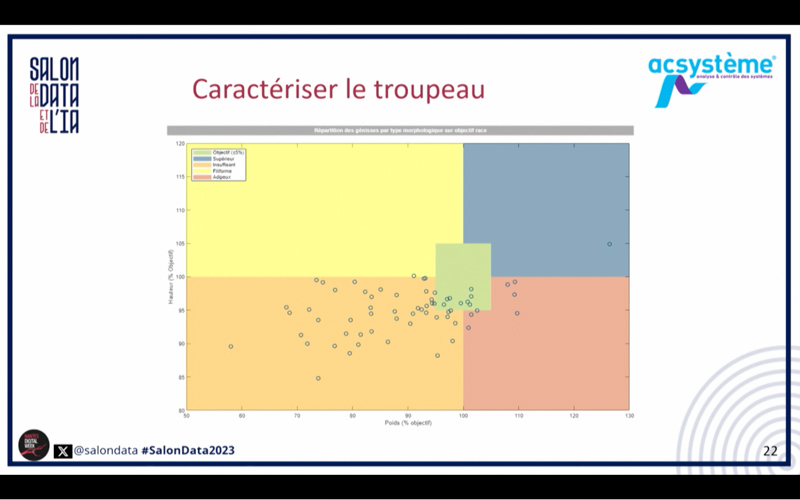

Mais revenons à nos moutons, la présentation faite par Stéphanie Lescarret d’Acsystèmes a été l’une des plus factuelles que j’ai vues lors de ce salon. Je pense que délivrer un outil aussi utile au métier que celui qu’elle a présenté devrait être le but ultime d’un projet data.

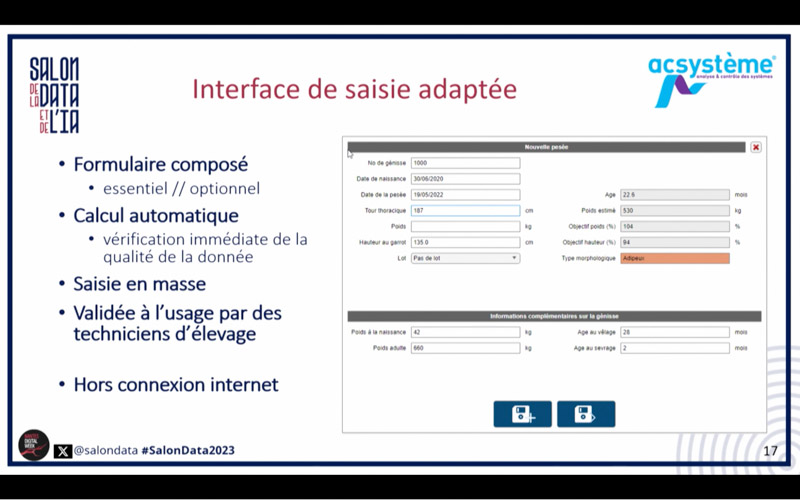

Sur ce projet, Acsystèmes a travaillé en partenariat avec le groupe CCPA afin de fournir aux éleveurs et techniciens d’élevage un outil de surveillance de la nutrition de leurs bovins (autre que le fichier Excel utilisé à la base).

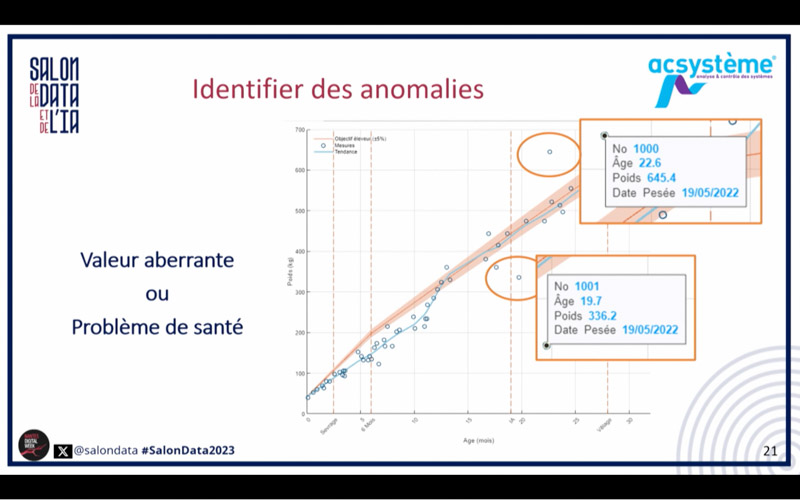

L’outil tourne autour de la collecte et de l’analyse des données de mensurations des vaches. Il se résume en une interface de saisie adaptée et des visualisations claires et actionnables par l’éleveur pour détecter d’éventuels problèmes de santé (pratique quand on a des dizaines de vaches à surveiller), se situer par rapport à un objectif de mensurations, et in fine optimiser sa production laitière.

Une solution simple et efficace, on adore !

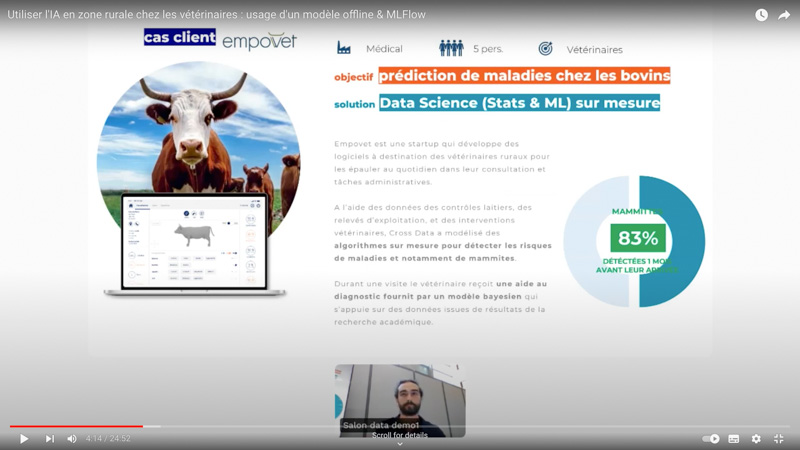

Et pour vous tou.te.s qui avez soif de technique, rassurez-vous, on peut aussi faire du Machine Learning à la ferme 😅

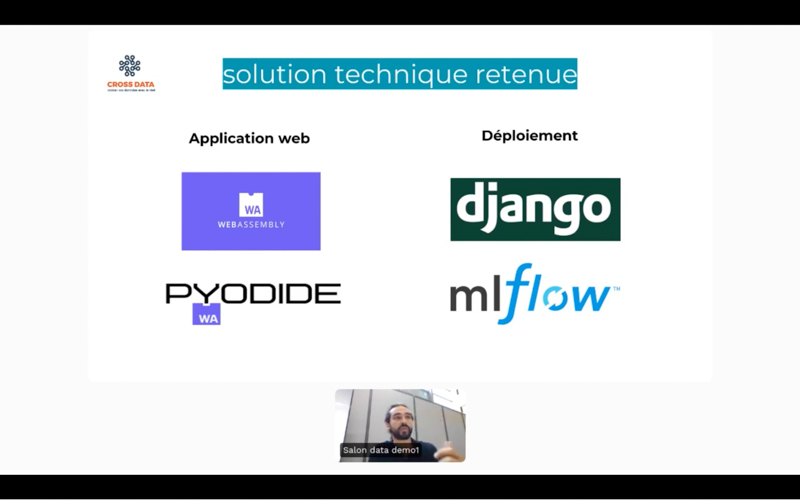

Pierre Girardeau de Cross Data nous a présenté une solution de ML Ops mise en place spécifiquement pour faire fonctionner des modèles de Machine Learning en zone blanche, c’est-à-dire sans accès internet. Ce qui signifie qu’on oublie les ressources Cloud (un comble pour un consultant Devoteam Revolve 😣).

La stack utilisée:

- un web server JavaScript et Pyodide (Web Assembly) pour embarquer les modèles sur un équipement et exécuter du code Python hors ligne

- MLFlow et Django pour le serving et la gestion du cycle de vie des modèles (les mises à jour sont réalisées dès qu’un accès internet est disponible)

Pour l’instant, le client n’utilise que des “modèles ne nécessitant pas beaucoup de ressources” à l’inférence, mais la solution semble être cohérente et “fonctionne sans altérer la performance des modèles”.

Vous êtes maintenant outillés si vous souhaitez aller faire un tour à la ferme prochainement !

De la technique, encore de la technique 🤌

Dans cette dernière partie de l’article (courage c’est bientôt fini!), on parle purement d’outillage technique en termes d’architecture Data, avec les présentations de Decathlon et Microsoft.

L’une des conférences les plus attendues du côté de mes collègues nantais était celle de Decathlon.

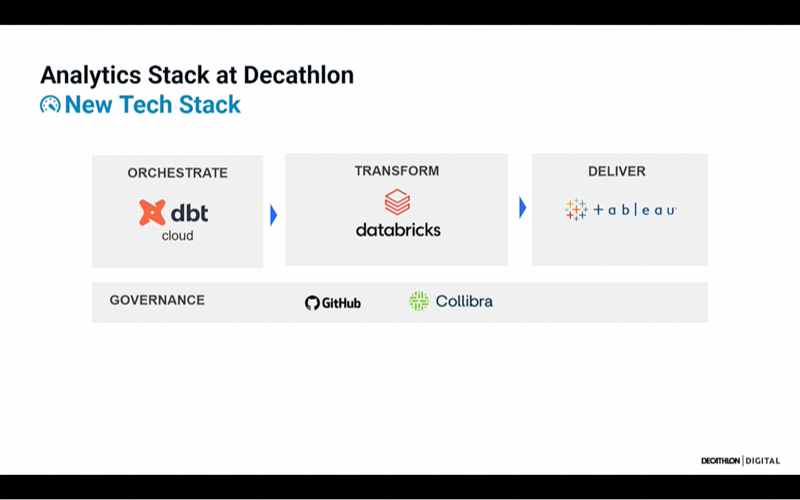

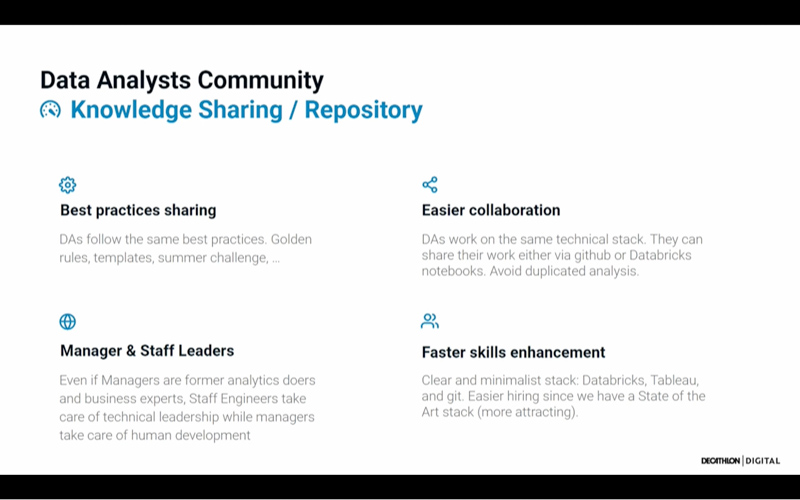

Anicet Bart et Hugo Hauraix nous ont présenté leur nouvelle stratégie et outils d’Analytics.

Historiquement, la stack technique chez Decathlon était très hétéroclite entre les équipes, ce qui contraignait les Data Analysts à maîtriser plusieurs outils (SQL ou R ou Python pour le développement, QlikSense ou Data Studio pour la visualisation, etc…).

La mise en place d’une stack technique Data minimaliste et unifiée a été un game changer car elle a permis de renforcer les possibilités de collaboration en termes de data analyse. Au-delà des outils choisis pour leur stack technique (ci-dessous), je pense que ce qu’il faut retenir ici c’est qu’unifier ET simplifier les process et outils Data au sein de l’entreprise ne peuvent qu’augmenter la productivité et la collaboration entre les profils Data.

Enfin, Eric Charbonnier, CTO offres Data et IA (France) chez Microsoft, a présenté Microsoft Fabric, une plateforme SaaS d’analytics définie par le speaker comme un “PowerBI on Steroid” qui “fait tout”. L’outil est encore en Preview pour l’instant. En gros Microsoft Fabric a pour vocation de permettre toutes les étapes d’analyse de la donnée jusqu’à la production de valeur dans un seul et même outil.

L’accent a également été mis sur la “Data Democratisation” qui permettrait un accès plus simple à la donnée grâce à de l’IA générative (j’ai quand même réussi à tenir jusqu’ici 😂), en permettant la production de dashboards en langage naturel par exemple.

Outil à évaluer donc (notamment en termes de coûts) par les profils data une fois qu’il sera GA!

Conclusion

Ce Salon de la Data et de l’IA à Nantes a été riche en apprentissages et en retours d’expériences tant surprenants qu’inspirants. Bien sûr je n’ai pas pu couvrir toutes les conférences, notamment celles de Blablacar, La Poste, My Money Bank ou encore Maisons du Monde.

Mais si le cœur vous en dit, je vous invite à regarder le replay des conférences qui ont piqué votre curiosité à la lecture de cet article et bien d’autres. N’hésitez pas à me dire ce que vous en aurez pensé!